简介

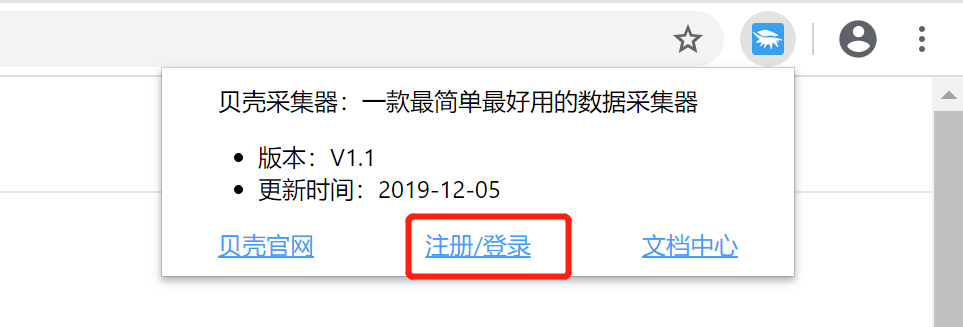

贝壳采集器是谷歌浏览器插件,同时也支持所有的基于谷歌内核的浏览器,比如360浏览器、QQ浏览器。可自动化提取网页数据,实现不敲代码,指哪爬哪的目标,属于居家出行杀人越货之必备神器。因为是集成在浏览器中,因此,想要获取数据,只需要在浏览器中安装此插件,登录贝壳采集平台后台,就可以使用了,是一个不是程序员也可以获取网页数据的神器。

安装方法及使用

1.安装插件

我们抓取数据一般都是什么场景呢,如果只是零星的几条数据或者特定的某条数据也就不值得用工具了,之所以用工具是因为要批量的获取数据,而用手工方式又太耗时费力,甚至根本不能完成。例如抓取微博热门前100条,当然可以一页一页的翻,但是实在是太耗精力,再比如说知乎某个问题的所有答案,有的热门问题回答数成千上万,手工来,还是省省吧。 基于这样的一种需求,一般可采用两种方式采集这些数据,一种是开发人员会根据需求自己写个爬虫或者利用某个爬虫框架,根据需求的复杂程度,敲代码的时长从一两个小时到一两天不等,当然如果时间太长的话可能是因为需求太复杂,针对这种复杂的需求来说,普通人的方式或许也就行不通了。常用的爬虫框架 Scrapy 另一种也是主要介绍的,也就是贝壳采集器这个工具,因为其界面简单、操作简单,并且可导出 Excel 格式,不懂开发的同学也可以很快上手。而且对于一些简单的需求,开发人员也没必要自己实现个爬虫,点几下鼠标毕竟要比敲半天代码快吧。

数据爬取的思路一般可以简单概括如下:

1、通过一个或多个入口地址,获取初始数据。例如一个文章列表页,或者具有某种规则的页面,例如带有分页的列表页;

2、根据入口页面的某些信息,例如链接指向,进入下一级页面,获取必要信息;

3、根据上一级的链接继续进入下一层,获取必要信息(此步骤可以无限循环下去); 原理大致如此,接下来通过实战正式认识一下贝壳采集器。