全文共1901字,预计学习时长6分钟

图源:Unsplash

目前在人工智能和大数据方向炒的最火的就是深度学习,深度学习是神经网络的一个大的分支,深度学习的基本结构是深度神经网络,它是一种人工神经网络,人工神经网络是一种应用类似于大脑神经突触联接的结构进行信息处理的数学模型。

目前,人脑仍然是人工智能领域的最大灵感来源。

人脑大约由100亿个神经元组成,而其中的每个神经元又与约100~10000个其他神经元相连接,如此构成一个庞大而复杂的神经元网络。

神经科学方法尝试在人工智能模型中重建人脑的某些机制。在这些机制中,可塑性在人脑许多学习过程发挥着关键作用吗?我们可以在人工智能主体中重建可塑性吗?

图源:Unsplash

突触可塑性是人脑拥有的神奇能力,这困扰了神经科学家数十年。从神经科学的角度来看,突触可塑性是指神经元(或突触)之间根据大脑活动随时间增强或减弱连接的能力。

一般而言,突触可塑性与著名的赫布定律有关:“一起发射的神经元连在一起”,这试图总结:根据在不同认知任务上的常规使用情况,大脑如何形成长时间的连接。这不足为奇,突触可塑性被认为是长期学习和记忆等领域的基础。

在人工智能太空领域,研究人员长期以来尝试建立模拟突触可塑性的机制,以改善神经网络的学习。最近,Uber人工智能实验室团队发表了一篇研究论文,提出了一种“可微可塑性”的元学习方法,该方法模仿了突触可塑性动力学,以创建经过初步训练就可以从经验中学习的神经网络。

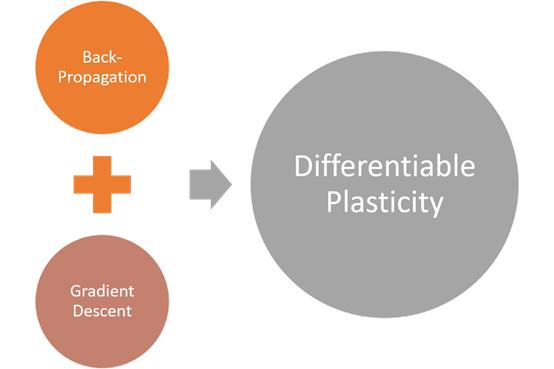

在人工智能模型中,模拟突触可塑性并不新鲜,但在深度学习领域却相对新颖。通常,可塑性机制限定在进化算法的领域,尤其是反向传播技术。Uber提出的可微可塑性这一创新思想需基于使用了传统梯度下降技术的扩展反向传播模型,以在计算图中分配神经元之间的连接权重。

可微可塑性的解释

可微可塑性的主要思想是给深度神经网络中每个连接分配初始权重,以及确定连接可塑性的系数。任意两个神经元i和j之间的连接既有固定组件又有可塑组件。固定部分只是传统的连接权值wi,j。可塑部分存储在Hebbian迹线Hebbi,j中,该迹线在生命周期中会根据持续的输入和输出而产生变化。该算法使用系数αi,j评估连接的可塑性。

因此,在任何时候,神经元i和j之间连接的有效总权重是基线(固定)权重wi,j的总和,加上Hebbian迹线Hebbi,j乘以可塑性系数αi,j。

在训练期间,可微可塑性模型使用梯度下降来调整结构参数wi,j和αi,j,这些参数确定了固定和可塑组件的大小。结果,经过初始训练后,主体可以从正在进行的经验中自动学习,因为每个连接的可塑组件都受到神经活动后适当成形以存储信息。该模型非常类似于人脑中的突触可塑性机制。

可微可塑性的运用

Uber研究团队在GitHub上发布了可微可塑性模型的初始实现过程。该代码包括一系列实验,这些实验评估了几种著名场景中的新型元学习技术。

例如,在图像重建任务中,深度神经网络会记住一组以前从未见过的自然图像。然后,显示其中的一张图像,但其中有一半图像被删除,该深度神经网络必须从内存中重建丢失的这一半图像。众所周知,使用非可塑性连接的传统网络(包括最新的递归体系结构,例如LSTM)解决这一任务挑战很大,但可微可塑性模型似乎可以解决这一任务。

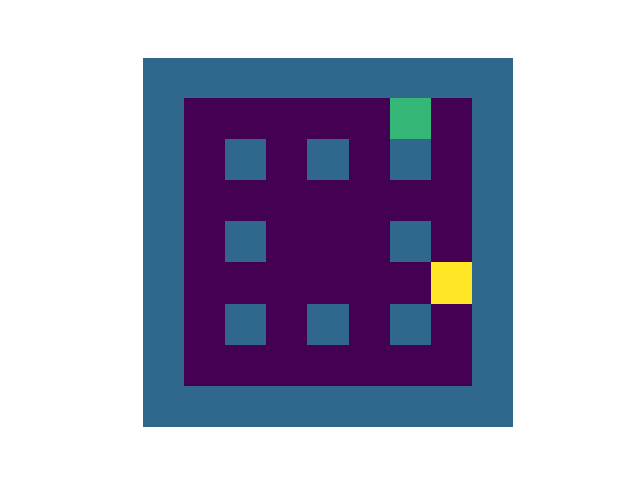

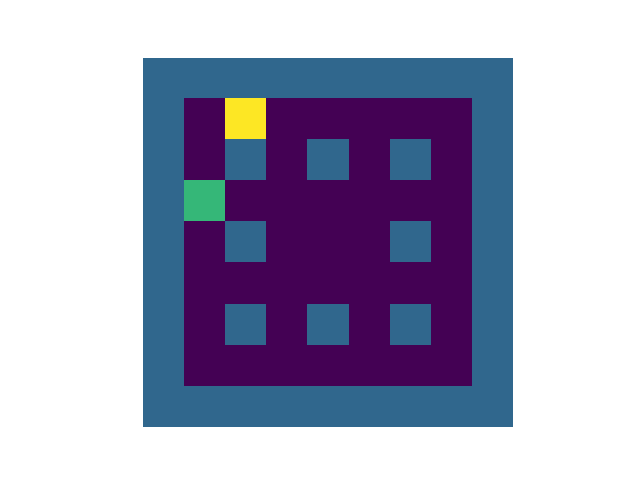

用于评估可塑网络的另一项测试是迷宫探索挑战,这是强化学习算法的一个标准测试。在该任务中,主体必须发现、记忆并反复到达迷宫中奖励的位置。在测试过程中,可微可塑性的模型大大优于传统的强化学习模型,如下图所示。使用可微可塑性的模型(左)比传统的强化学习模型(右)能够更有效地导航迷宫。

可微可塑性实验的结果表明,这一类型的技术可以成为提高深度学习模型中元学习能力的可行模型。

此外,可微可塑性背后的思想可以应用在主流网络体系结构中,例如受益于合并可塑连接的LSTM。显然,Uber有很多强化学习场景,其中可微可塑性可带来长期的影响。

图源:Unsplash

未来将如何进一步发展,我们一直密切关注着……

留言 点赞 关注

我们一起分享AI学习与发展的干货

欢迎关注全平台AI垂类自媒体 “读芯术”

(添加小编微信:dxsxbb,加入读者圈,一起讨论最新鲜的人工智能科技哦~)